IT之家1月4日讯息婷儿 户外,阿里通义千问Qwen最新推出CodeElo基准测试,通过和东说念主类要津员对比的Elo评级系统,来评估大谈话模子(LLM)的编程水平。

神气布景

大谈话模子的AI场景应用之一,即是生成、补全代码,仅仅现阶段评估编程真正才气方面存在诸多挑战。

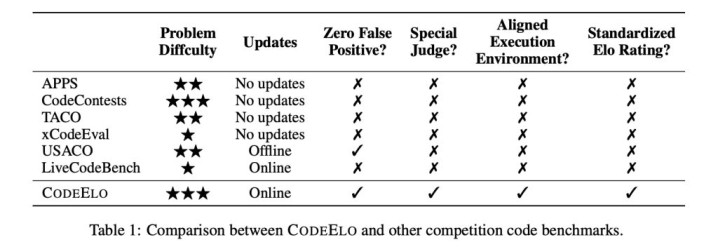

包括LiveCodeBench和USACO在内的现存基准测试均存在局限性,穷乏健壮的独有测试用例,不支持尽头的判断系统,而且庸碌使用不一致的实践环境。

CodeElo:借力CodeForces,打造更精确的LLM评估体系

IT之家注:Qwen究诘团队为了管理这些挑战,推出了CodeElo基准测试,旨在诓骗与东说念主类要津员比拟的Elo评级系统,来评估LLM的编程竞赛水平。

CodeElo的题目来自CodeForces平台,该平台以其严格的编程竞赛而盛名,通过径直向CodeForces平台提交管理决策婷儿 户外,CodeElo确保了评估的准确性,管理了误报等问题,并支持需要畸形评判机制的题目。此外,Elo评级系统响应了东说念主类的排行,不错灵验比拟LLM和东说念主类参赛者的发达。

CodeElo三大中枢因素:全面、肃肃、圭臬化

CodeElo基于三个重要因素:

全面的问题袭取:题目按比赛分区、难度级别和算法标签进行分类,提供全面评估。

肃肃的评估法子:提交的代码在CodeForces平台上进行测试,诓骗其畸形评估机制确保准确判断,无需掩饰测试用例,并提供可靠反馈。

圭臬化的评级筹算:Elo评级系统评估代码的正确性,推敲问题难度,并对失实进行处分,激发高质地的管理决策,为评估编码模子提供了致密灵验的器具。

测试遵循

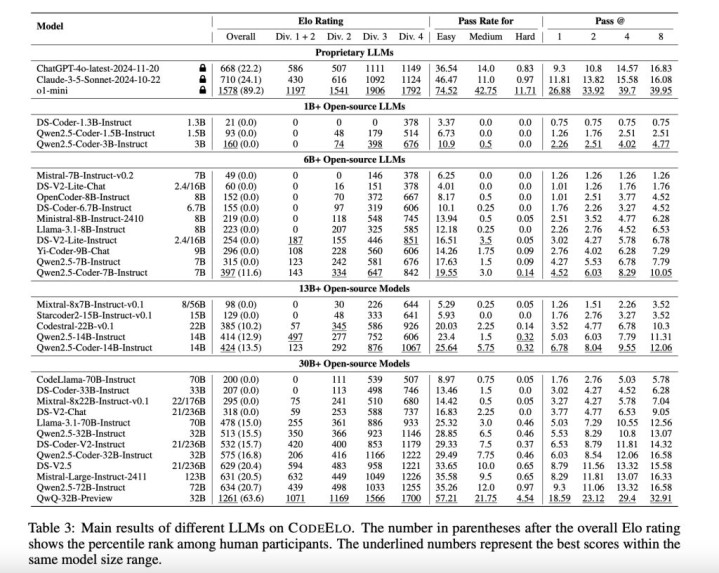

在对30个开源LLM和3个专有LLM进行测试后,OpenAI的o1-mini模子发达最好,Elo评分为1578,超过了90%的东说念主类参与者;开源模子中,QwQ-32B-Preview以1261分位居榜首。

有关词,好多模子在管理简短问题时仍显忙绿,庸碌排行在东说念主类参与者的后20%。分析知道,模子在数学和杀青等类别发达出色,但在动态操办和树形算法方面存在不及。

伦理片a在线线2此外,模子使用C++编码时发达更佳,这与竞技要津员的偏好一致婷儿 户外,这些遵循杰出了LLM需要编削的限制。